Índice del contenido[Esconder][Espectáculo]

En los últimos años, los modelos de aprendizaje profundo se han vuelto más efectivos para comprender el lenguaje humano.

Piensa en proyectos como GPT-3, que ahora puede crear artículos y sitios web completos. GitHub ha introducido recientemente Copiloto de GitHub, un servicio que proporciona fragmentos de código completos simplemente describiendo el tipo de código que necesita.

Los investigadores de OpenAI, Facebook y Google han estado trabajando en formas de utilizar el aprendizaje profundo para manejar otra tarea: subtitular imágenes. Usando un gran conjunto de datos con millones de entradas, han llegado a algunos sorprendente dE TRATAMIENTOS.

Últimamente, estos investigadores han intentado realizar la tarea contraria: crear imágenes a partir de un pie de foto. ¿Es ahora posible crear una imagen completamente nueva a partir de una descripción?

Esta guía explorará dos de los modelos de texto a imagen más avanzados: DALL-E 2 de OpenAI e Imagen AI de Google. Cada uno de estos proyectos ha introducido métodos innovadores que pueden cambiar la sociedad tal como la conocemos.

Pero primero, comprendamos a qué nos referimos con generación de texto a imagen.

¿Qué es la generación de texto a imagen?

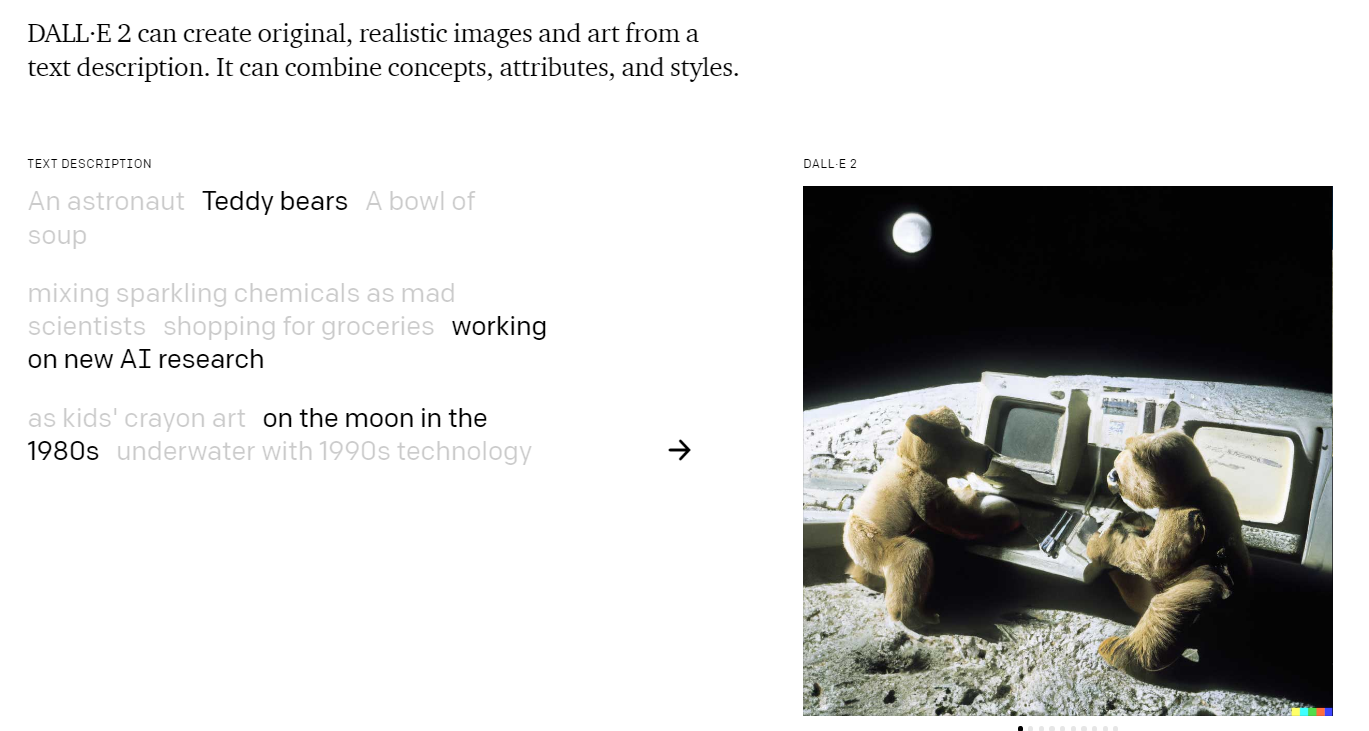

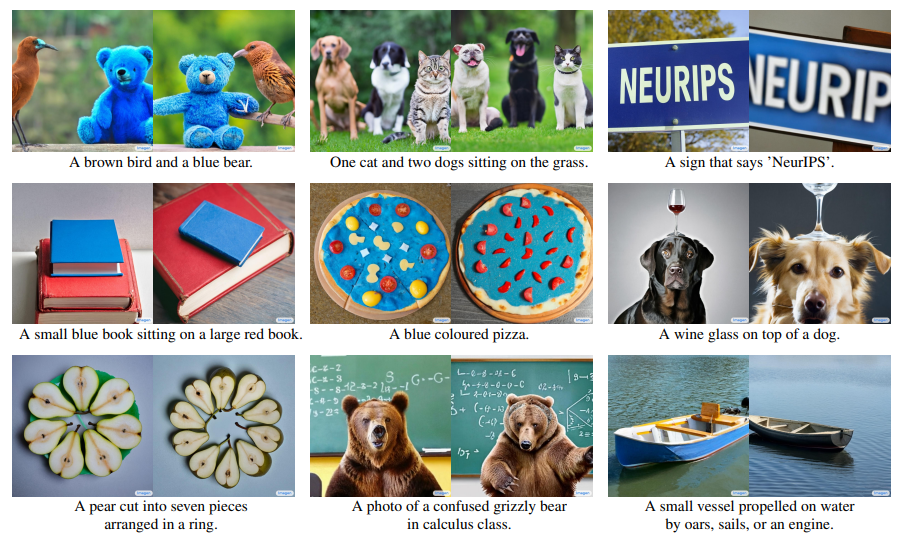

Modelos de texto a imagen Permita que las computadoras creen imágenes nuevas y únicas basadas en indicaciones. Las personas ahora pueden proporcionar una descripción de texto de una imagen que desean producir, y el modelo intentará crear una imagen que coincida lo más posible con esa descripción.

Los modelos de aprendizaje automático han aprovechado el uso de grandes conjuntos de datos que contienen pares de leyendas de imágenes para mejorar aún más el rendimiento.

La mayoría de texto a imagen los modelos usan un modelo de lenguaje transformador para interpretar indicaciones. Este tipo de modelo es un red neural que trata de aprender el contexto y el significado semántico del lenguaje natural.

A continuación, modelos generativos como modelos de difusión y las redes antagónicas generativas se utilizan para la síntesis de imágenes.

¿Qué es DALLE 2?

DALL-E2 es un modelo de computadora de OpenAI que se lanzó en abril de 2022. El modelo se entrenó en una base de datos de millones de imágenes etiquetadas para asociar palabras y frases a las imágenes.

Los usuarios pueden escribir una frase simple, como "un gato comiendo lasaña", y DALL-E 2 generará su propia interpretación de lo que la frase intenta describir.

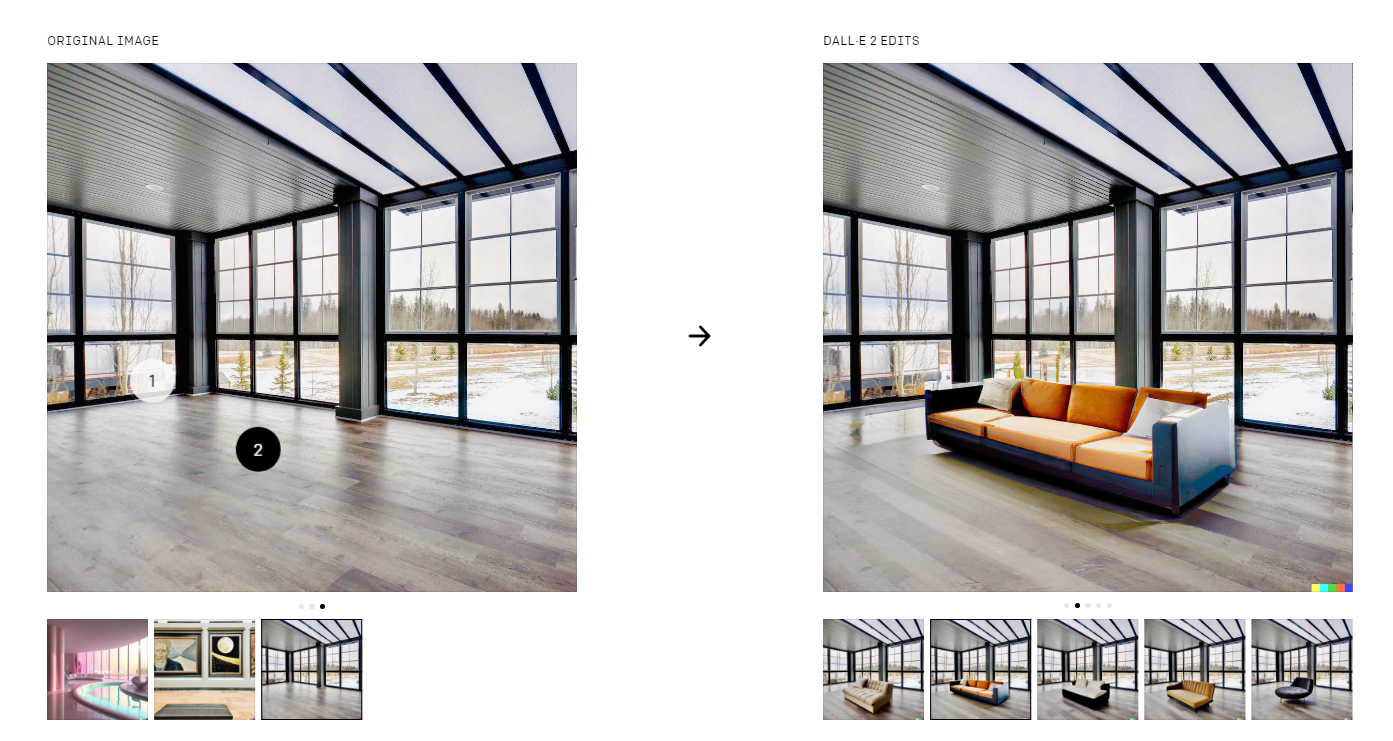

Además de crear imágenes desde cero, DALL-E 2 también puede editar imágenes existentes. En el siguiente ejemplo, DALL-E pudo generar una imagen modificada de una habitación con un sofá adicional.

DALL-E 2 es solo uno de los muchos proyectos similares que OpenAI ha lanzado en los últimos años. El GPT-3 de OpenAI se convirtió en noticia cuando parecía generar texto de diferentes estilos.

Actualmente, DALL-E 2 todavía está en pruebas beta. Los usuarios interesados pueden registrarse para su Lista de espera y esperar el acceso.

¿Cómo Funciona?

Si bien los resultados de DALL-E 2 son impresionantes, es posible que se pregunte cómo funciona todo.

DALL-E 2 es un ejemplo de una implementación multimodal del proyecto GPT-3 de OpenAI.

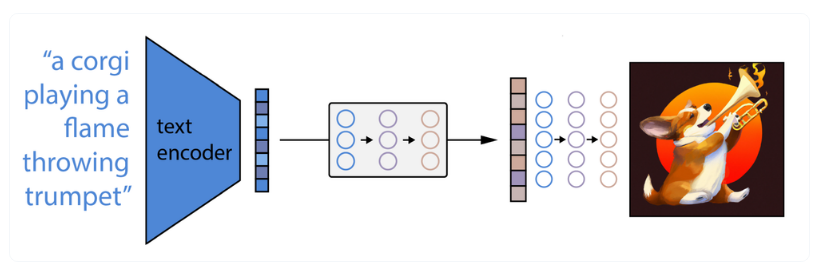

Primero, el indicador de texto del usuario se coloca en un codificador de texto que asigna el indicador a un espacio de representación. DALL-E 2 utiliza otro modelo de OpenAI llamado CLIP (Contrastive Language-Image Pre-Training) para obtener información semántica del lenguaje natural.

A continuación, un modelo conocido como el antes mapea la codificación de texto en una codificación de imagen. Esta codificación de imágenes debe capturar la información semántica encontrada en el paso de codificación de texto.

Para crear la imagen real, DALL-E 2 usa un decodificador de imágenes para generar una imagen usando información semántica y detalles de codificación de imágenes. OpenAI utiliza una versión modificada del PLANEO modelo para realizar la generación de imágenes. GLIDE se basa en un modelo de difusión para crear imágenes.

La adición de GLIDE al modelo DALL-E 2 permitió una salida más fotorrealista. Dado que el modelo GLIDE es estocástico o se determina aleatoriamente, el modelo DALL-E 2 puede crear fácilmente variaciones ejecutando el modelo una y otra vez.

Limitaciones

A pesar de los impresionantes resultados del modelo DALL-E 2, todavía enfrenta algunas limitaciones.

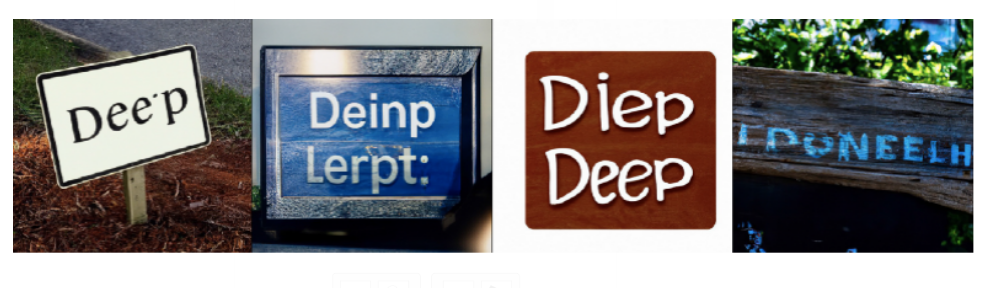

Texto de ortografía

Las indicaciones que intentan hacer que DALL-E 2 genere texto revelan que tiene dificultades para deletrear palabras. Los expertos suponen que esto puede deberse a que la información ortográfica no forma parte del conjunto de datos de entrenamiento.

Razonamiento composicional

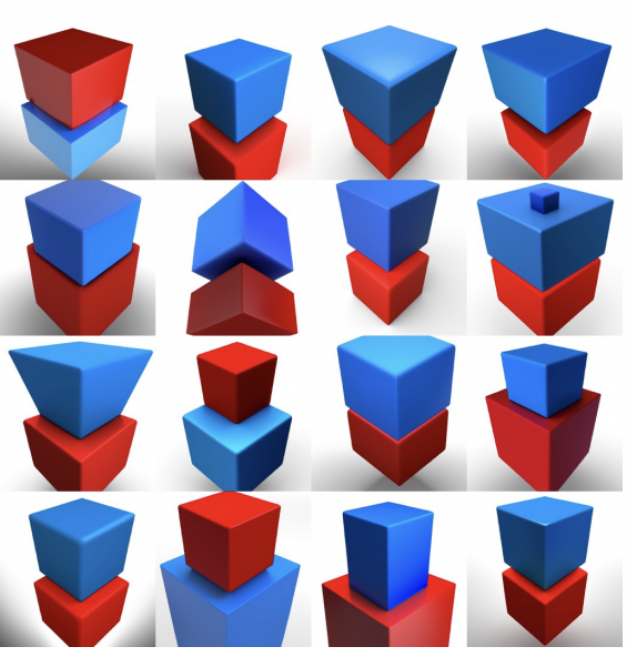

Los investigadores observan que DALL-E 2 todavía tiene algunas dificultades con el razonamiento compositivo. En pocas palabras, el modelo puede comprender aspectos individuales de una imagen sin dejar de tener problemas para descubrir las relaciones entre estos aspectos.

Por ejemplo, si se le indica "cubo rojo encima de un cubo azul", DALL-E generará un cubo azul y un cubo rojo con precisión, pero no los colocará correctamente. También se ha observado que el modelo tiene dificultades con las indicaciones que requieren extraer una cantidad específica de objetos.

Sesgo en el conjunto de datos

Si el mensaje no contiene otros detalles, se ha observado que DALL-E representa personas y entornos blancos u occidentales. Este sesgo de representación se produce debido a la abundancia de imágenes centradas en Occidente en el conjunto de datos.

También se ha observado que el modelo sigue los estereotipos de género. Por ejemplo, escribir la indicación "azafata de vuelo" genera principalmente imágenes de mujeres azafatas.

¿Qué es Google Imagen AI?

De Google Imagen IA es un modelo que tiene como objetivo crear imágenes fotorrealistas a partir de texto de entrada. Similar a DALL-E, el modelo también utiliza modelos de lenguaje transformador para comprender el texto y se basa en el uso de modelos de difusión para crear imágenes de alta calidad.

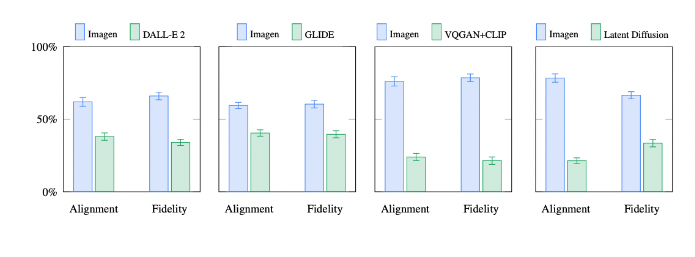

Junto con Imagen, Google también ha lanzado un punto de referencia para modelos de texto a imagen llamado DrawBench. Usando DrawBench, pudieron observar que los evaluadores humanos preferían la salida de Imagen sobre otros modelos, incluido DALL-E 2.

¿Cómo Funciona?

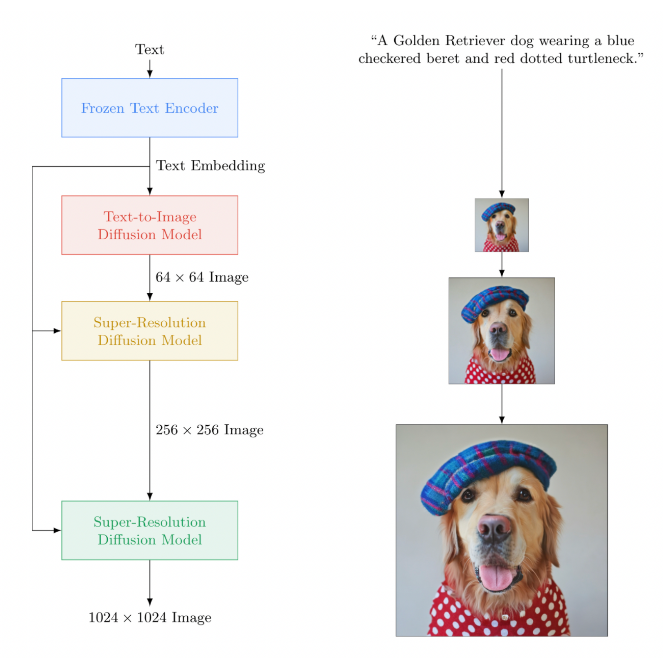

Similar a DALL-E, Imagen primero convierte el aviso del usuario en un texto incrustado a través de un codificador de texto congelado.

Imagen utiliza un modelo de difusión que aprende a convertir un patrón de ruido en imágenes. La salida inicial de estas imágenes es de baja resolución y luego se pasan a través de otro modelo conocido como modelo de difusión de súper resolución para aumentar la resolución de la imagen final. El primer modelo de difusión genera una imagen de 64 × 64 píxeles y luego se amplía a una imagen de alta resolución de 1024 × 1024.

Según la investigación del equipo de Imagen, los grandes modelos de lenguaje congelado entrenados solo en datos de texto siguen siendo codificadores de texto altamente efectivos para la generación de texto a imagen.

El estudio también introduce el concepto de umbralización dinámica. Este método permite que las imágenes parezcan más fotorrealistas al aumentar los pesos de orientación al generar la imagen.

Rendimiento de DALLE 2 vs Imagen

Los resultados preliminares del benchmark de Google muestran que los encuestados humanos prefieren imágenes generadas por Imagen sobre DALL-E 2 y otros modelos de texto a imagen como Latent Diffusion y VQGAN+CLIP.

Los resultados del equipo de Imagen también han demostrado que su modelo se desempeña mejor en la ortografía del texto, una debilidad conocida del modelo DALL-E 2.

Sin embargo, dado que Google aún no ha lanzado el modelo al público, aún queda por ver qué tan precisos son los puntos de referencia de Google.

Conclusión

El surgimiento de modelos fotorrealistas de texto a imagen es controvertido porque estos modelos están listos para un uso poco ético.

La tecnología puede conducir a la creación de contenido explícito o como herramienta para la desinformación. Los investigadores de Google y OpenAI son conscientes de esto, y en parte es por eso que estas tecnologías aún no son accesibles para todos.

Los modelos de texto a imagen también tienen importantes implicaciones económicas. ¿Se verán afectadas profesiones como modelos, fotógrafos y artistas si modelos como DALL-E se generalizan?

De momento, estos modelos siguen teniendo limitaciones. Sostener cualquier imagen generada por IA para examinarla revelará sus imperfecciones. Con OpenAI y Google compitiendo por los modelos más efectivos, puede ser cuestión de tiempo antes de que se genere un resultado verdaderamente perfecto: una imagen que no se pueda distinguir de la real.

¿Qué crees que pasará cuando la tecnología llegue tan lejos?

Deje un comentario