Klasycznym problemem sztucznej inteligencji jest pogoń za maszyną rozumiejącą ludzki język.

Na przykład podczas wyszukiwania „włoskich restauracji w pobliżu” w Twojej ulubionej wyszukiwarce algorytm musi przeanalizować każde słowo w zapytaniu i wyświetlić odpowiednie wyniki. Przyzwoita aplikacja do tłumaczenia będzie musiała rozumieć kontekst konkretnego słowa w języku angielskim i jakoś uwzględniać różnice gramatyczne między językami.

Wszystkie te zadania i wiele innych należą do poddziedziny informatyki znanej jako Przetwarzanie języka naturalnego lub NLP. Postępy w NLP doprowadziły do powstania szerokiej gamy praktycznych aplikacji, od wirtualnych asystentów, takich jak Alexa firmy Amazon, po filtry antyspamowe wykrywające złośliwe wiadomości e-mail.

Najnowszym przełomem w NLP jest idea tzw duży model językowy lub LLM. LLM, takie jak GPT-3, stały się tak potężne, że wydają się odnosić sukcesy w prawie każdym zadaniu lub przypadku użycia NLP.

W tym artykule przyjrzymy się, czym dokładnie są LLM, w jaki sposób te modele są szkolone i jakie mają obecne ograniczenia.

Co to jest duży model językowy?

W swej istocie model językowy jest po prostu algorytmem, który wie, jakie jest prawdopodobieństwo, że sekwencja słów jest poprawnym zdaniem.

Bardzo prosty model językowy wytrenowany na kilkuset książkach powinien być w stanie stwierdzić, że „Poszedł do domu” jest bardziej trafny niż „Poszedł do domu”.

Jeśli zastąpimy stosunkowo mały zbiór danych ogromnym zbiorem danych zeskrobanym z Internetu, zaczniemy zbliżać się do idei a duży model językowy.

Korzystanie z sieci neuronowe, badacze mogą szkolić LLM na dużej ilości danych tekstowych. Ze względu na ilość danych tekstowych, które widział model, LLM staje się bardzo dobry w przewidywaniu następnego słowa w sekwencji.

Model staje się tak wyrafinowany, że może wykonywać wiele zadań NLP. Zadania te obejmują streszczanie tekstu, tworzenie nowych treści, a nawet symulowanie ludzkiej rozmowy.

Na przykład bardzo popularny model językowy GPT-3 jest trenowany z ponad 175 miliardami parametrów i jest uważany za najbardziej zaawansowany model językowy do tej pory.

Jest w stanie wygenerować działający kod, napisać całe artykuły i spróbować odpowiedzieć na pytania na dowolny temat.

Jak szkoli się LLM?

Pokrótce poruszyliśmy fakt, że LLM zawdzięczają dużą moc swojej mocy rozmiarowi swoich danych treningowych. Nie bez powodu nazywamy je w końcu „dużymi” modelami językowymi.

Trening wstępny z architekturą transformatora

Na etapie szkolenia wstępnego LLM są wprowadzane do istniejących danych tekstowych, aby poznać ogólną strukturę i zasady języka.

W ciągu ostatnich kilku lat LLM zostały wstępnie przeszkolone w zakresie zbiorów danych, które obejmują znaczną część publicznego Internetu. Na przykład model językowy GPT-3 został przeszkolony na danych z Wspólne indeksowanie zestaw danych, zbiór postów internetowych, stron internetowych i zdigitalizowanych książek zebranych z ponad 50 milionów domen.

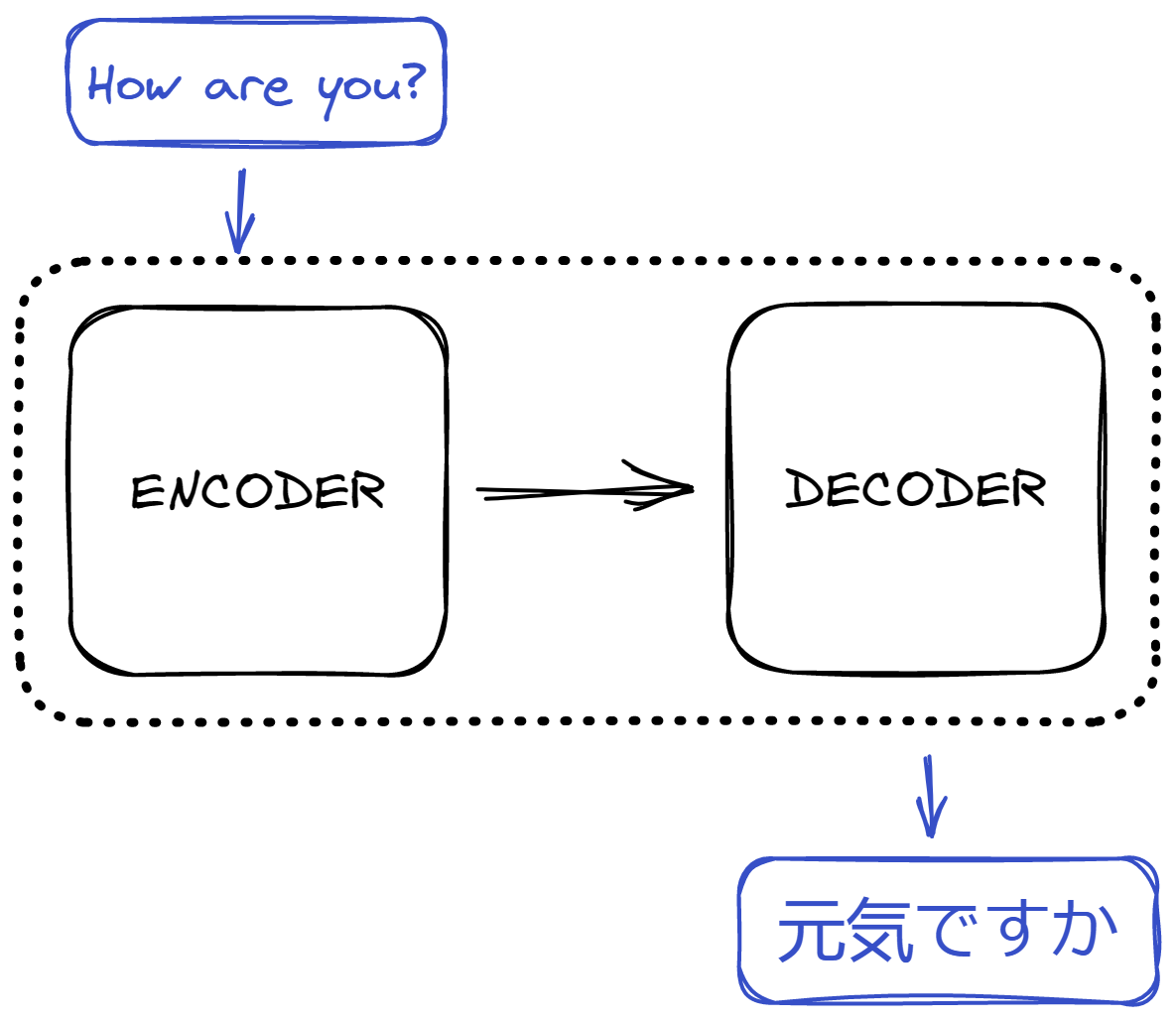

Ogromny zbiór danych jest następnie wprowadzany do modelu znanego jako a transformator. Transformatory są rodzajem głęboka sieć neuronowa najlepiej sprawdza się w przypadku danych sekwencyjnych.

Transformatory używają architektura koder-dekoder do obsługi wejścia i wyjścia. Zasadniczo transformator zawiera dwie sieci neuronowe: koder i dekoder. Koder może wyodrębnić znaczenie tekstu wejściowego i zapisać go jako wektor. Następnie dekoder odbiera wektor i tworzy własną interpretację tekstu.

Jednak kluczową koncepcją, która umożliwiła tak dobre działanie architektury transformatora, jest dodanie a mechanizm samouwagi. Koncepcja samouwagi pozwoliła modelowi zwrócić uwagę na najważniejsze słowa w danym zdaniu. Mechanizm uwzględnia nawet wagi między słowami, które są daleko od siebie sekwencyjnie.

Inną zaletą samouważności jest to, że proces można zrównoleglić. Zamiast przetwarzać dane sekwencyjne po kolei, modele transformatorów mogą przetwarzać wszystkie dane wejściowe jednocześnie. Umożliwia to transformatorom relatywnie szybkie trenowanie na ogromnych ilościach danych w porównaniu z innymi metodami.

Strojenie

Po etapie szkolenia wstępnego możesz wprowadzić nowy tekst dla podstawowego LLM do trenowania. Nazywamy ten proces strojenie i jest często używany do dalszej poprawy wydajności LLM w przypadku określonego zadania.

Na przykład możesz chcieć użyć LLM do generowania treści dla swojego konta na Twitterze. Możemy dostarczyć modelowi kilka przykładów twoich poprzednich tweetów, aby dać mu wyobrażenie o pożądanym wyniku.

Istnieje kilka różnych rodzajów dostrajania.

Niewielka nauka odnosi się do procesu dostarczania modelowi niewielkiej liczby przykładów z oczekiwaniem, że model językowy wymyśli, jak uzyskać podobne wyniki. Nauka jednorazowa jest podobnym procesem, z wyjątkiem tego, że podano tylko jeden przykład.

Ograniczenia dużych modeli językowych

LLM, takie jak GPT-3, są w stanie wykonać dużą liczbę przypadków użycia, nawet bez dostrajania. Jednak te modele nadal mają swój własny zestaw ograniczeń.

Brak semantycznego rozumienia świata

Z pozoru LLM wydają się wykazywać inteligencję. Jednak te modele nie działają w ten sam sposób ludzki mózg robi. LLM polegają wyłącznie na obliczeniach statystycznych w celu generowania danych wyjściowych. Nie mają zdolności samodzielnego uzasadniania pomysłów i koncepcji.

Z tego powodu LLM może generować bezsensowne odpowiedzi po prostu dlatego, że słowa wydają się „właściwe” lub „statystycznie prawdopodobne”, gdy są umieszczone w tej konkretnej kolejności.

Halucynacje

Modele takie jak GPT-3 również cierpią z powodu niedokładnych odpowiedzi. LLM mogą cierpieć z powodu zjawiska znanego jako halucynacja gdzie modele wyprowadzają błędną merytorycznie odpowiedź bez świadomości, że odpowiedź nie ma podstaw w rzeczywistości.

Na przykład użytkownik może poprosić modelkę o wyjaśnienie przemyśleń Steve'a Jobsa na temat najnowszego iPhone'a. Model może generować wycenę z powietrza na podstawie swoich danych treningowych.

Uprzedzenia i ograniczona wiedza

Podobnie jak wiele innych algorytmów, duże modele językowe są podatne na dziedziczenie błędów obecnych w danych treningowych. Ponieważ zaczynamy polegać bardziej na LLM w celu wyszukiwania informacji, twórcy tych modeli powinni znaleźć sposoby na złagodzenie potencjalnie szkodliwych skutków tendencyjnych odpowiedzi.

W podobny sposób martwe punkty danych treningowych modelu będą również utrudniać sam model. Obecnie trenowanie dużych modeli językowych zajmuje miesiące. Modele te opierają się również na zestawach danych o ograniczonym zakresie. Właśnie dlatego ChatGPT ma ograniczoną wiedzę na temat wydarzeń, które miały miejsce po 2021 roku.

Wnioski

Duże modele językowe mogą naprawdę zmienić sposób, w jaki wchodzimy w interakcje z technologią i ogólnie z naszym światem.

Ogromna ilość danych dostępnych w Internecie dała naukowcom możliwość modelowania złożoności języka. Jednak po drodze wydaje się, że te modele językowe przyjęły ludzkie rozumienie świata takim, jakim jest.

Ponieważ opinia publiczna zaczyna ufać tym modelom językowym, aby zapewnić dokładne wyniki, badacze i programiści już znajdują sposoby na dodanie barier, aby technologia pozostała etyczna.

Jak myślisz, jaka jest przyszłość LLM?

Dodaj komentarz